Temui Tantangan ETL Data IoT dan Maksimalkan ROI

Organisasi dapat mengoptimalkan data IoT, dengan cepat dan hemat biaya memperoleh nilai bisnisnya dengan mengembangkan keahlian dalam teknologi ETL (extract, transfer, load).

Potensi IoT tidak pernah sebesar ini. Dengan investasi pada perangkat berkemampuan IoT yang diperkirakan akan meningkat dua kali lipat pada tahun 2021 dan peluang yang melonjak di segmen data dan analitik, tugas utamanya adalah mengatasi tantangan dan menjinakkan biaya di sekitarnya Proyek data IoT.

Organisasi dapat mengoptimalkan data IoT, dengan cepat dan hemat biaya memperoleh nilai bisnisnya dengan mengembangkan keahlian dalam teknologi ETL (extract, transfer, load), seperti pemrosesan aliran dan datalakes.

Lihat juga: 4 Prinsip untuk Mengaktifkan Data Lake Asli

Namun, di banyak organisasi, hal ini dapat menyebabkan kemacetan TI, penundaan proyek yang lama, dan ilmu data ditangguhkan. Hasil:Proyek IoT – di mana data analitik prediktif dimaksudkan untuk memainkan peran penting dalam meningkatkan efisiensi operasional dan memacu inovasi – masih belum melewati ambang batas pembuktian konsep dan pasti tidak dapat menunjukkan ROI.

Pahami Tantangan ETL yang Dihadapi IoT

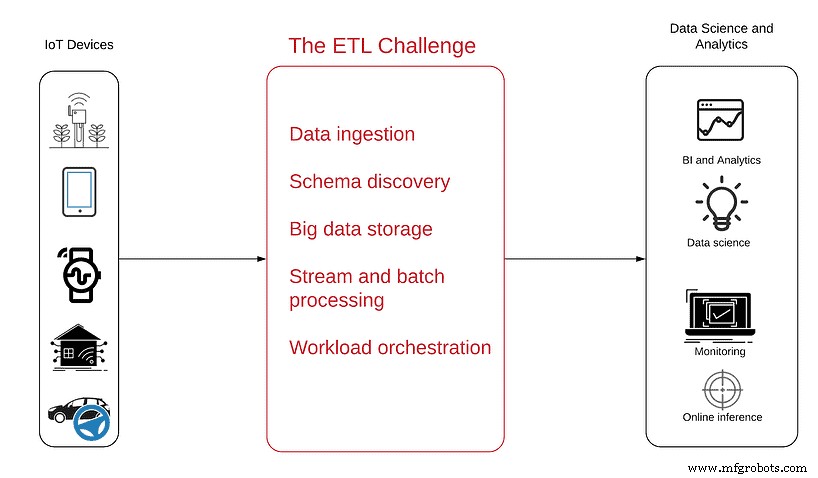

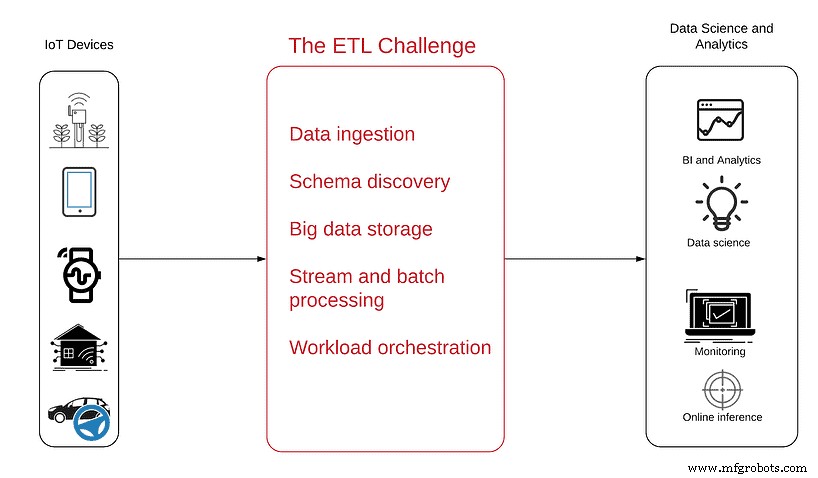

Diagram berikut akan membantu Anda memahami masalah dengan lebih baik:

Sumber data ada di sebelah kiri – perangkat penuh sensor yang tak terhitung banyaknya, dari antena sederhana hingga kendaraan otonom rumit yang menghasilkan data IoT dan mengirimkannya sebagai aliran data semi-terstruktur yang tidak terputus melalui web.

Di sebelah kanan adalah tujuan yang harus dicapai oleh konsumsi data tersebut, dengan produk analitik yang dihasilkan pada akhir proyek, termasuk:

- Kecerdasan bisnis untuk mendapatkan visibilitas tentang tren dan pola penggunaan produk

- Pemantauan operasional untuk melihat pemadaman dan perangkat tidak aktif secara real-time

- Deteksi anomali untuk mendapatkan peringatan proaktif tentang puncak atau penurunan tajam dalam data

- Analisis tersemat untuk memungkinkan pelanggan melihat dan memahami data penggunaan mereka sendiri

- Ilmu data untuk menikmati manfaat analitik canggih dan pembelajaran mesin dalam pemeliharaan prediktif, pengoptimalan rute, atau pengembangan AI

Untuk mencapai tujuan ini, Anda harus terlebih dahulu mengubah data dari mode streaming mentah menjadi tabel siap analitik yang dapat ditanyakan dengan SQL dan alat analitik lainnya.

Proses ETL seringkali merupakan segmen yang paling sulit dipahami dari setiap proyek analitik karena data IoT berisi serangkaian kualitas unik yang tidak selalu sinkron dengan database relasional, ETL, dan alat BI yang biasa. Misalnya:

- Data IoT mengalirkan data, terus dibuat dalam file kecil yang terakumulasi menjadi kumpulan data yang besar dan luas. Ini sangat berbeda dari data tabular tradisional dan memerlukan ETL yang lebih kompleks untuk melakukan penggabungan, agregasi, dan pengayaan data.

- Data IoT harus disimpan sekarang, dianalisis nanti. Tidak seperti kumpulan data pada umumnya, volume data yang dibuat oleh perangkat IoT berarti bahwa data tersebut harus memiliki tempat duduk sebelum dapat dianalisis – cloud atau data lake di lokasi.

- Data IoT menyajikan peristiwa yang tidak berurutan karena beberapa perangkat yang dapat bergerak masuk dan keluar dari area konektivitas Internet. Ini berarti log dapat mencapai server pada waktu yang berbeda dan tidak selalu dalam urutan yang “benar”.

- Data IoT sering kali membutuhkan akses latensi rendah. Secara operasional, Anda mungkin harus mengidentifikasi anomali atau perangkat tertentu secara real time atau mendekati real time, sehingga Anda tidak dapat membayar latensi yang disebabkan oleh pemrosesan batch.

Haruskah Anda Menggunakan Kerangka Kerja Sumber Terbuka untuk Membuat Data Lake?

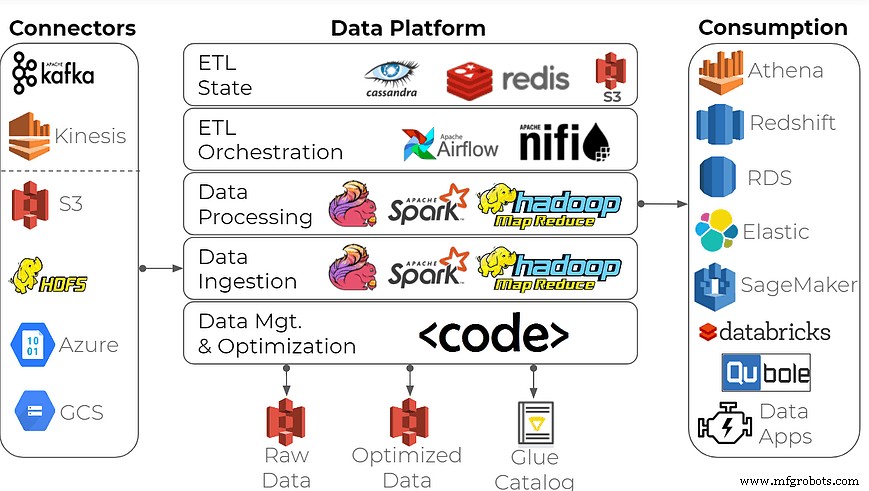

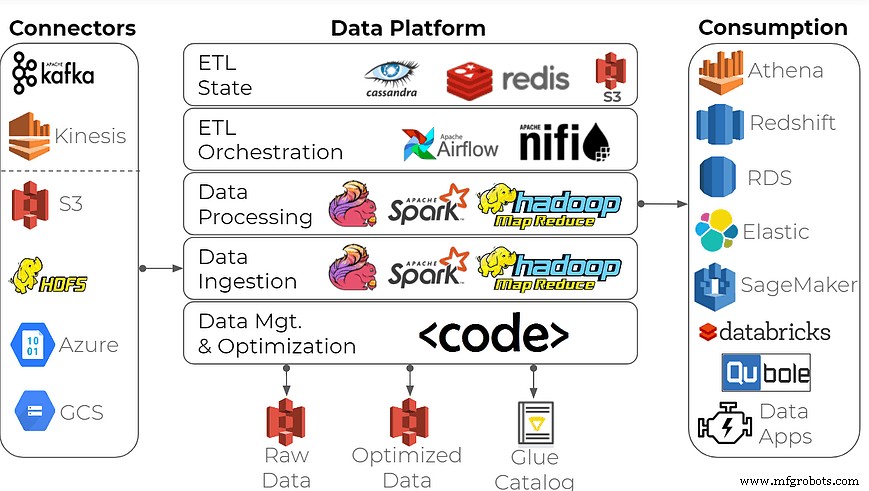

Untuk membangun platform data perusahaan untuk analitik data, banyak organisasi menggunakan pendekatan umum ini:membuat data lake menggunakan kerangka kerja pemrosesan aliran sumber terbuka sebagai blok pembangun ditambah database deret waktu seperti Apache Spark/Hadoop, Apache Flink, InfluxDB, dan lainnya.

Bisakah perangkat ini melakukan pekerjaan itu? Tentu, tetapi melakukannya dengan benar bisa sangat melelahkan bagi semua kecuali perusahaan yang paling berpengalaman dengan data. Membangun platform data seperti itu menuntut keterampilan khusus para insinyur bigdata dan perhatian yang kuat pada infrastruktur data – biasanya tidak sesuai dengan manufaktur dan elektronik konsumen, industri yang bekerja erat dengan data IoT. Harapkan pengiriman yang terlambat, biaya yang mahal, dan banyak jam teknis yang terbuang sia-sia.

Jika organisasi Anda menginginkan kinerja tinggi plus berbagai fungsi dan kasus penggunaan – pelaporan operasional, analitik ad-hoc, dan persiapan data untuk pembelajaran mesin – maka adopsi solusi yang sesuai. Contohnya adalah menggunakan platform ETL data lake yang dibuat khusus untuk mengonversi aliran menjadi kumpulan data yang siap analitik.

Solusinya tidak kaku dan kompleks seperti platform data Spark/Hadoop. Itu dibangun dengan antarmuka pengguna swalayan dan SQL, bukan pengkodean intens di Java/Scala. Untuk analis, ilmuwan data, manajer produk, dan penyedia data di DevOps dan rekayasa data, ini bisa menjadi alat yang benar-benar ramah pengguna yang:

- Menyediakan layanan mandiri untuk konsumen data tanpa perlu bergantung pada TI dan rekayasa data

- Mengoptimalkan aliran ETL dan penyimpanan data besar untuk mengurangi biaya infrastruktur

- Memungkinkan organisasi, berkat layanan yang terkelola sepenuhnya, untuk fokus pada fitur daripada infrastruktur

- Menghilangkan kebutuhan untuk memelihara beberapa sistem untuk data real-time, analitik ad hoc, dan pelaporan

- Memastikan bahwa data tidak pernah keluar dari akun AWS pelanggan untuk keamanan total

Anda dapat memperoleh manfaat dari data IoT – hanya diperlukan alat yang tepat untuk membuatnya berguna.